知识库问答系统使用说明

知识库问答系统使用说明

Leon1. 主要组件入口

- FastGpt: http://192.168.13.16:3000

- OneApi: http://192.168.13.16:3001

- Xinference: http://192.168.13.16:9997

- Notebook: http://192.168.13.16:8890

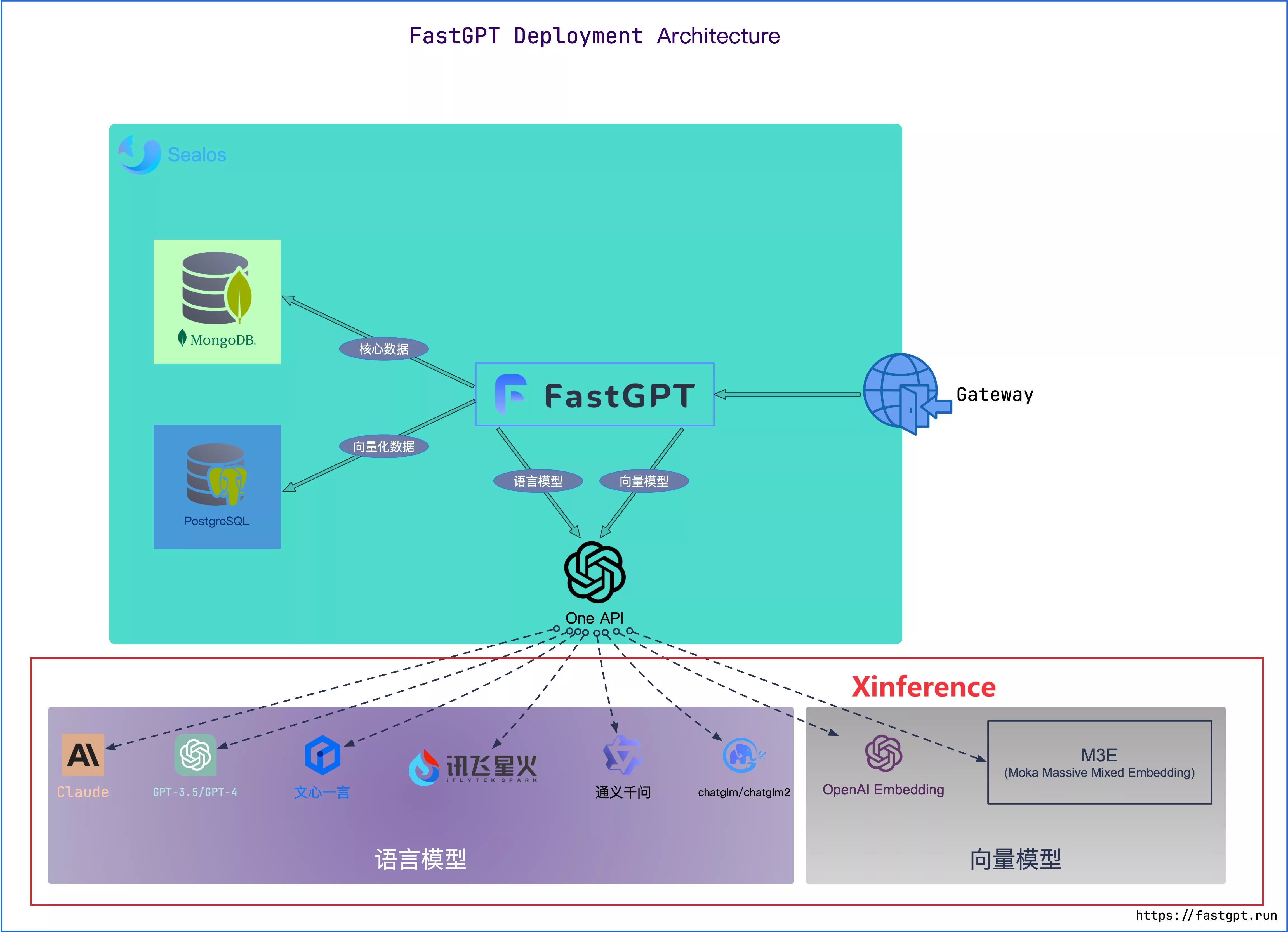

2. 主要组件说明

- FastGpt: 知识库问答系统

- OneApi: 各种本地部署和在线部署AI模型的API接口管理和分发系统。

- Xinference: 各种 AI 模型的本地部署和集成平台,当前它部署智谱的GLM-4-9b-chat语言模型和bge-large-zh-v1.5量化模型。

- Notebook: 魔搭社区提供的容器镜像,集成全套魔搭工具链的Notebook,可以下载、运行和微调模型。如后面要微调模型,可以参考魔搭社区的说明在Notebook里执行,微调后在Xinference里部署。平时可以不运行。

3. 更换本地模型的流程

- 登录Xinference,选择启动要使用的模型,大语言模型建议同时只运行一个,多余的要先关掉,具体操作参考里的指南。

- 修改init.sh,使每次重启后模型能自动部署。

- 登录OneApi,在渠道里xinference下进入编辑,修改模型选项,密钥随便写。在令牌里编辑fastgpt,调整模型范围。

- 修改config.json文件,具体参考。

- 执行

./fastgpt.sh reload重建集群。 - 登录FastGpt,新建应用就可以看到新的模型了。

4. 主要维护操作

在目录/home/leonvo/fastgpt下运行

- 启动FastGpt相关组件

1

2

3

4

5

6

7

8

9

10启动FastGpt相关组件

./fastgpt.sh start

停止FastGpt相关组件

./fastgpt.sh stop

重启FastGpt相关组件

./fastgpt.sh restart

重建FastGpt相关组件, 更换模型,改完config.json和init.sh后需要执行,否则不生效

./fastgpt.sh reload

查看FastGpt集群日志

./fastgpt.sh logs - notebook容器相关操作使用

./notebook.sh {start|stop|restart|reload|logs}, 与上同

5. 主要文件和目录说明

在目录/home/leonvo/fastgpt下

- config.json: FastGpt的模型配置文件,如换模型,需要修改,详见

- init.sh: 给Xinference的启动脚本,Xinference的容器在启动时不会运行之前部署的模型,这个脚本会自动部署GLM-4-9b-chat和bge-large-zh-v1.5,如换模型,需要修改。

- docker-compose-notebook.yml: notebook的docker-compose文件。

- docker-compose.yml: FastGPT和Xinference的docker-compose文件。

- Dockerfile.Xinference: Xinference容器文件,在原容器里增加模型自动启动功能。

- fastgpt.sh: FastGpt的管理脚本,实现FastGpt集群的启动和重启等

- notebook.sh: notebook的管理脚本,实现notebook容器的启动和重启等

- Xinference目录: Xinference和notebook容器本地部署模型的缓存路径.

- notebook目录: notebook的ipynb文件保存路径。